Мета тег robots запрещающий установила в коды своих сайтов. Это нужно сделать чтобы предотвратить попадания в индексы поисковых систем различных дубликатов статей. Длительное время на моих сайтах был установлен файл robots.txt. Однако в индексах Яндекса и Гугла постоянно находила дубликаты. Потому что индексировались: категории, их страницы, теги, архивы, страницы вложения, файлы автора и др.

Мета тег robots запрещающий — как установить в код сайта

Дополняла в файл robots.txt новые директории, однако все было бесполезно. Потому решила установить еще мета тег. Его особенно рекомендует Гугл, для запрещения страниц.Индексы моих сайтов выросли до больших размеров. Они в несколько крат превышали количество написанных текстов. Эти же дубли влекут за собой и другие ошибки. Например, слишком длинные заголовки, отсутствующие мета описания.

В Интернете несколько раз видела предложения об установке мета-тега robots noindex и nofollow в заголовок сайта. Пробовала устанавливать, но не получалось. Наконец мне встретилась статья об установке его в файл functions.php. Код скопировала в блокнот, представляет он собой следующую запись.

Код для вставки

Скопируем его здесь и вставим в плагин функций. Плагин функций можно найти в интернете сделав запрос в поиске.

function mayak_meta_robots () {<br>if (is_archive() or is_category() or is_feed () or is_author() or is_date() or is_day() or is_month() or is_year() or is_tag() or is_tax() or is_attachment() or is_paged() or is_search()) <br>{<br>echo "".'<meta name="robots" content="noindex,nofollow" />'."\n";<br>}<br>}<br>add_action('wp_head', 'mayak_meta_robots');

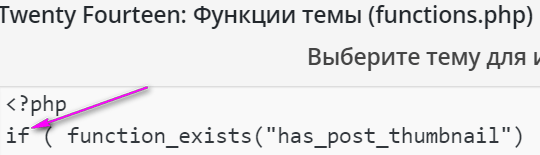

Название сайта mayak — это автор кода, заменять его не нужно. Копируем код сразу после <?php, с новой строки, как на записи. Но у меня появился плагин функций. Этот код и другие устанавливаю в плагин, а не в файл функций. Статья была написана в 2015 году, но запрещающий метатег стоит у меня до настоящего времени в плагине — 2021 -2023 годы.

Сейчас все пользуются плагином — Yoast SEO. У меня о нем есть большая статья.

Мета тег robots — с другими плагинами

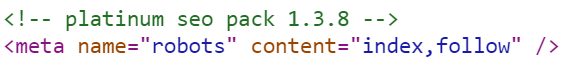

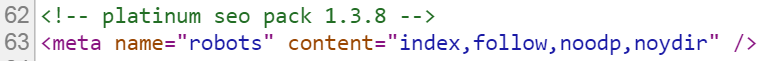

Но с самого начала на сайте у всех блогеров работал плагин Platinum SEO. Однако и в его настройках можно убрать все запреты, тогда в коде получиться index follow. По теории автора, /кстати, подобные статьи встретила еще у двух ведущих блогеров/. Робот сможет свободно пройти до самого запретительного мета-тега, который ему не позволит индексировать запрещенные файлы. Но для этого нужно преобразовать файл robots.txt следующим образом:

| 1 2 3 4 5 6 | User-agent: * Allow: /wp-content/uploads Disallow: /wp- Host:moylubimiblog.ru Sitemap:https://moylubimiblog.ru/sitemap.xml.gz Sitemap:https://moylubimiblog.ru/sitemap.xml |

То есть роботу Гугла запрещено все, что находится в Word Press. Однако позже файл robots.txt изменяла несколько раз, для Гугла. И продолжаю вносить в него изменения периодически.

Что Гугл индексирует, до сих пор не понятно. Например, у моих сайтов, там отсутствует много статей. Можно сделать заявку на индексацию, но часто их робот не находит статьи на сайте. Пишет, что произошла ошибка, но не известно какая. Или, например, находит с 3-4 попыток. Но потом может быть сообщения, что 2-3 ресурса не загружены из-за блокировки в файле robots.txt. Сей час, в 20 23 году Гугл все еще находит у меня не индексированные статьи. Однако их стало не более 3- 7, и такое небольшое количество легко исправляю.

Мета тег robots запрещающий — результаты установки

Все так и сделала, результатов ждала 3-4 месяца, однако ничего не происходило. Сайты в индексе Яндекса выглядели хуже, чем в Гугле. Но в 2021 году, все наоборот. Например, мои сайты Гугл посещает в 2 раза меньше, чем Яндекс.

В 2015 году не вытерпела, и файлы вложения стала удалять активно, но они оставались в индексе на протяжении года. Наконец обратилась в Яндекс поддержку. Платон мне вежливо ответил, что если есть противоречия в запретах, то робот выбирает разрешающую функцию. У меня был именно такой случай: мета-тег создавал запрет — noindex, nofollow, а плагин Platinum SEO, при снятых галочках, генерирует в коде – index, follow.

На одном сайте оставила, как советовали ведущие блогеры, а на другом вернула запреты в чекбоксы плагина Platinum SEO.

В Гугле долго все оставалось по-прежнему. Как будто мета-тег robots не функционировал. Но потом сообщения о блокировке совсем исчезли. Их нет уже несколько лет. Статьи блогера о мета-теге robots мне помогли. Но далеко не сразу, примерно в течение года.

Дополнительная коррекция файла robots.txt только для Яндекса

Не ладилось вначале, затем заменила SEO плагин, устанавливала совсем простой. Позже заменила его на Yoast. В файле robots.txt для Гугла вход свободный, запрещает его только мета тег. Для Яндекса делаю дополнительные запреты в файле robots.txt. Но запрещаю только те файлы, которые он неправильно проиндексировал. Сейчас с этим вопросом все в порядке мета-тег robots хорошо функционирует и заблокированные ресурсы в Google исчезли. Они постоянно то исчезают, то опять появляются. Но сейчас блокируется не вся статья, а только ряд затронутых ресурсов.